前回の作品作りの過程で、FaceGenで作った時の顔イメージと、DAZ Studioに顔データを出力した後の顔イメージとに違いがあることが明らかになりました。原理的には同じになるはずなので、どこか違いがないか調べてみました。その結果のレンダリング画像とSketchfabで公開したものを紹介します。

違いを調査した結果は?

一番可能性が高いと思われたベースフィギアの顔データの違いについて調べてみました。というのは、FaceGenで作られた顔データそのものがDAZ Studioで再現されるのではなく、Genesisというベースフィギアの顔データと合成されて再現されるからです。

このために、DAZ Studioに出力された顔データは、そのままでは再現されず、モーフパラメーターを1.0にすることによって再現されます。モーフパラメーターは0から1まで連続的に可変できるので、例えば0.5の時は、Genesisの顔とFaceGenの顔のちょうど中間となる顔で再現されます。

おそらく何らかのモーフターゲットが影響しているのではないかという仮説を立てて、関係がありそうなモーフパラメーターを全て確認しましたが、全ての値が0でした。

この結果から、今回の仮説は実証できませんでした。今後も引き続き別の原因を考えて調査をするつもりです。

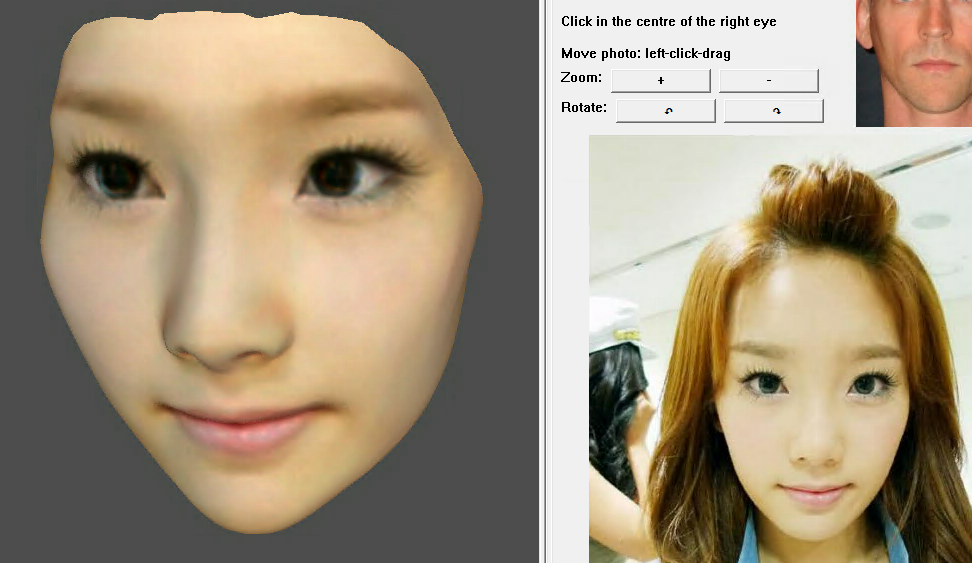

FaceGenで使った顔写真を同一人物の別の写真に置き換えてみると?

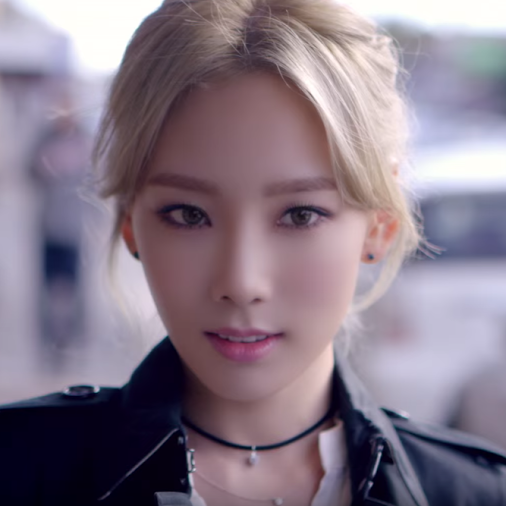

前回使った顔写真は以下のようなものでした。

これを、もう少しFaceGenが認識しやすいような顔写真を探して置き換えてみました。以下がその顔写真です。

認識するアルゴリズムはわからないので、この写真が本当に認識しやすいかどうかはわかりませんが、私の勘だとおそらくこちらの方が認識しやすいと思います。

FaceGenが生成したイメージは以下です。

かなりな精度で似ていると思います。これをDAZ Studioに出力してレンダリングしてみました。

かなりな精度で似ていると思います。これをDAZ Studioに出力してレンダリングしてみました。

レンダリング結果

こんな感じになりました。ライティングは前回と同じIBLで行っています。

今回は前回よりかなり似たイメージになりました。やはり元の顔写真によって似方が変わるようです。かなり微妙なので、法則がまだわかりませんが、ノウハウ的な顔写真の選び方は確立できそうです。

もちろんかなりの回数というか顔写真のケーススタディーを行う必要がありそうです。

Sketchfabに公開したイメージ

今回はこんな感じにしてみました。

操作方法は、スタートした後、マウスの場合は、左ボタンドラッグ(回転)、右ボタンドラッグ(移動)、ホイール(拡大縮小)でカメラ操作ができます。

スマホ/タブレットは、スワイプ(回転)、ダブルスワイプ(移動)、ピンチ(拡大縮小)です。

Taey-04-2

by kirayan4852

on Sketchfab

髪の毛がコートの襟を突き抜けているのはご愛嬌ということで・・・髪の毛はあまり細かい動きは付けられないのが難点です。通常はポストワークのレタッチで消すのですが、Sketchfabではそういう誤魔化しができない難しさがあります。

Poser 10

まとめ

Sketchfabに新しい機能としてアニメーションも公開できるようになったみたいですが、まだ手付かずです。

アニメーションができるのであれば、ダイナミッククロスとダイナミックヘアーを使って、風になびく髪とスカートを表現してみたいですが、けっこう時間がかかるのでいつになるか・・・

FaceGen関連の記事は一段落したので次の話題に進もうかと思いましたが、あと一人の作品も作っておかなければと思い返して、もう一人の作品を作る予定です。

本来なら3人セットの作品も作りたいところですが、DAZ Studioでは3人は厳しいですね。おそらく動かなくなると思います。

PoserであればVueという景観ソフトと連携すれば、私の過去の実績では10人くらいまでならバックの景色付きでOKでした。

DAZ Studioで3人セットのレンダリング作品を作るには、今のところ一人づつレンダリングして2DグラフィックソフトかWebアプリで合成するのが最も簡単な方法ですね。そこまでやるか・・・

【3DCG】DAZ Studio4でダイナミッククロス&ヘアーを使ってみる?!

ではでは、きらやん